Diferenças entre edições de "Regressão linear"

| Linha 1: | Linha 1: | ||

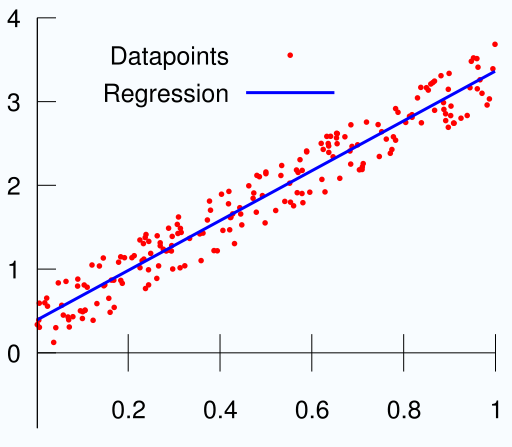

| + | [[Image:LinearRegression.png|thumb|200px|Exemplo de regressão linear.]] | ||

Em [[Estatística|estatística]], '''regressão linear''' é um método para se estimar a condicional (valor esperado) de uma variável ''y'', dados os valores de algumas outras variáveis ''x''. | Em [[Estatística|estatística]], '''regressão linear''' é um método para se estimar a condicional (valor esperado) de uma variável ''y'', dados os valores de algumas outras variáveis ''x''. | ||

Edição atual desde as 12h27min de 13 de outubro de 2008

Em estatística, regressão linear é um método para se estimar a condicional (valor esperado) de uma variável y, dados os valores de algumas outras variáveis x.

Em estatística, regressão linear é um método para se estimar a condicional (valor esperado) de uma variável y, dados os valores de algumas outras variáveis x.

A regressão, em geral, trata da questão de se estimar um valor condicional esperado.

A regressão linear é chamada "linear" porque se considera que a relação da resposta às variáveis é uma função linear de alguns parâmetros. Os modelos de regressão que não são uma função linear dos parâmetros se chamam modelos de regressão não-linear.

Índice

Equação da Regressão Linear

Para se estimar o valor esperado, usa-se de uma equação, que determina a relação entre ambas as variáveis.

Em que:

- Variável explicada (dependente); é o valor que se quer atingir;

- É uma constante, que representa a intercepção da recta com o eixo vertical;

- É outra constante, que representa o declive da recta;

- Variável explicativa (independente), representa o factor explicativo na equação;

- Variável que inclui todos os factores residuais mais os possíveis erros de medição. O seu comportamento é aleatório, devido à natureza dos factores que encerra. Para que essa fórmula possa ser aplicada, os erros devem satisfazer determinadas hipóteses, que são: serem variáveis normais, com a mesma variância

(desconhecida), independentes e independentes da variável explicativa X.

Cálculo dos factores  e

e

Definindo e

, temos que

e

se relacionam por:

Desenvolvimento

O objectivo é determinar e

de forma que a soma dos quadrados dos erros seja mínima, ou seja, devemos minimizar

Desenvolvendo este quadrado e eliminando os termos constantes (ou seja, aqueles que não têm termos em e

, chega-se a:

A partir desse ponto, pode-se resolver usando-se cálculo (tomando as derivadas parciais, etc), ou através de uma transformação de coordenadas:

ou

Transformando a expressão a ser minimizada em:

ou

Esta expressão se separa na soma de duas expressões quadráticas independentes, que podem ser minimizadas usando matemática elementar:

Cujos valores minimizadores são:

Memorização

Uma forma fácil de memorizar esta expressão é escrever:

e, em seguida, somar as colunas:

Intervalos de confiança

O valor estimato de ,

, deve ser analisado através da distribuição t de Student, porque

tem a distribuição t de Student com n-2 graus de liberdade (ver Fisher, R. A. (1925). "Applications of "Student's" distribution". Metron 5: 90–104.), em que:

A variância de ,

pode ser estimada através dos erros observados:

se distribui como uma Chi quadrado com n-2 graus de liberdade.

Bibliografia

- REIS, E., Estatistica Descritiva (2ª ed.). Lisboa: Edições Sílabo, 1994

| |

Esta página usa conteúdo da Wikipedia. O artigo original estava em Regressão_linear. Tal como o Think Finance neste artigo, o texto da Wikipedia está disponível segundo a GNU Free Documentation License. |